Участвовать в конкурсе, организованном Ботмастер Лабс, не планировал. Время нету, видео нужно для конкурса, как новомодное веяние, хоть легче все хорошими скринами можно объяснить (моё ИМХО), да и палить особо не хочется ничего. Тем уж очень мало осталось прибыльных, тупой спам уже совсем не рулит, тут нужно думать и темы никто палить не будет, если только отжившие попытаться в красивую обвёрку засунуть и припудрить немного. :) Но это не про нас. Вобщем, эти 3 "не", думаю, в основном и стали барьерами для участия в конкурсе для большинства потенциальных участников. Тут как с ремонтом машины из трех: дешево, качественно, быстро - в сервисе могут только 2 условия одновременно выполнить. сиди и выбирай, что тебе ближе. :) С конкурсом тоже самое: есть время, умею делать видео, но нету темы, или умею делать видео, есть тема, но нету совсем времени, или же и время свободное появилось и темка небольшая есть, но видео пугает. Но это хорошо ,если одновременно 2 условия выполняются. Ну, да ладно, отбросим лирику. Я про себя продолжу. Не планировал, значит, я в конкурсе участвовать, даже выбрал за какую статью голосовать буду. Что ни говори, а Доз очень хорошо софт знает и очень толково его применять умеет. Но сегодня узнал, что в конкурсе интрига появилась. Оказывается я голосовать не смогу, а смогут это делать только новички, кто приобрел софт в 2011 году и конкурс рассчитан на них. Удивился немного, но хозяин - барин. Конкурс - это рекламная компания и Александру виднее, как ее проводить. Вобщем, решил тогда выложить статью, несколько легче писать, когда ясно для кого, для всего колхоза на самом деле это сделать невозможно.

Длинное вступление закончилось, теперь к сути.

Что нужно новичку, когда он приобрел такой супер-комбайн, которым является комплекс Xrumer+Hrefer? Правильно, научиться на нем работать и отбросить иллюзии, что, начав спамить простынями, можно заработать деньги. Если вы так думаете, лучше сразу пожертвуйте ваши деньги на благотворительность. Вам нужно научиться использовать инструменты комплекса, желательно затачивая его под себя. Время "бери больше - кидай дальше" ушло. Количество уступает место качеству. Значит будем собирать базу под себя, не научитесь это делать - отстанете от поезда. В этом нам поможет, естественно, Хрефер. Если вы планируете продвигать свои ресурсы в Гугле, то и искать сайты-доноры нам нужно также через Гугл. Думаю, это понятно и логично. Но Гугл, как хозяйка медной горы, всем подряд свои богатства не отдает. К нему подход нужен. Сразу хотел бы сказать, что не надейтесь, что по признакам, которые вы найдете в паблике вы что-то сможете собрать. Они оттого и доступны в паблике, что грош им цена. Дальше тему развивать не буду. Лучше расскажу, как правильно собирать, чтобы вы увидели результат, остальное сами доработаете, главное понять принцип. Собирать по правильному нужно по признакам конкретных, нужных нам движков, а не признакам форумов вообще. Это главная ошибка новичков - не сконцентрироваться на конкретном, а пытаться охватить все целиком. И еще, если хотите напарсить более-менее нормальную базу, откажитесь от использования в запросах операторов. Никаких "inurl:", "site:", "title" и т.д. Гугл таких как вы искателей забанит моментально. Поэтому тщательно изучаем движки, с которыми в настоящий момент работает Хрумер:

Jive Forums

WowBB Forums

FuseTalk

SMF Forums

phpBB

IPB

VBulletin

YaBB

BMForum

Web Wiz Forums

punBB

bbPress

MyBB

UBB.classic

UltimateBB

Powered by php-Fusion

В версии Хрумер 7,07 программа обучена нескольким новым движкам:MyBB

SLAED CMS

zenPHOTO

forumi.biz, forumb.biz, 1forum.biz, 7forum.biz и т.п.

Amiro CMS

phpBB-fr.com, Solaris phpBB theme

shop-script.ru

И процесс обучения новому идет непрерывно.Вобщем, нам нужно готовить правильные запросы для парсинга Хрефером. Возьмем для примера форумный дижок SMF Forums. И начнем разбирать его на запчасти для парсинга. В этом нам поможет наш любимый Гугл. Вводим в Гугл запрос SMF Forums - много мусора в выдаче, отматываем на какую-нибудь 13-ю страницу и выбираем любую ссылку. Мне попалась на глаза вот такая: http://www.volcanohost.com/forum/index.php?topic=11.0 . Открываем ее и изучем. Нам нужно найти на странице что-то характерное, что можно применить к поиску других страниц на данном движке. В футере замечаем следующую надпись Powered by SMF 1.1.14, кавычим её и вводим в Гугл, он нам показывает, что по данному запросу он знает около 59 млн вариантов. Бегло просматриваем ссылки, добавляем к данному ключевику еще парочку-другую вариантов, например, "Powered by SMF 1.1.14" тополь либо "Powered by SMF 1.1.14" viagra. Убеждаемся, что запрос шикарный, в выдаче только форумы и почти никакого тебе мусора.

Нам же кроме того, не количество интересно, а качество, как я говорил выше. Идем дальше. Из того же форума берем еще одну фразу из футера: 2006-2008, Simple Machines LLC, также ее кавычим и скармливаем Гуглу. В ответ он показывает, что ему известно более 13 млн результатов. Снова бегло просматриваем выдачу, добавляем допслова и проверяем выдачу с ними. Убеждаемся, что запрос отличный и также почти нету мусора. Вобщем, уже есть 2 железных запроса. Я предлагаю, первый форум пока оставить в покое и продолжить собирать запросы уже по другим форумам. Благо Гугл у нас открыт по запросу 2006-2008, Simple Machines LLC. Берем из выдачи, например, эти форумы: http://www.snowlinks.ru/forum/index.php?topic=1062.0 и http://litputnik.ru/forum/index.php?action=printpage;topic=380.0 в футерах у них берем следующие запросы: "Powered by SMF 1.1.7" и "Powered by SMF 1.1.10" (вбивать для Хрефера запросы всегда советую закавыченными, ведь нам качество нужно в первую очередь). Думаю, понятно, что мы делаем, в конце концов у нас соберется некая база запросов для поиска форумов на движке СМФ (он выбран для примера, с остальными движками аналогично).

Выглядеть это будет примерно так:

"Powered by SMF 1.1.2"

"Powered by SMF 1.1.3"

"Powered by SMF 1.1 RC2"

"Powered by SMF 1.1.4"

"Powered by SMF 1.1.8"

....

"Powered by SMF 1.1.7"

"2006-2008, Simple Machines LLC"

Причем и это еще не всё. Собирая версии движков мы на некоторых форумах СМФ в футере обнаруживаем надвись "2001-2006, Lewis Media". Проверяем этот запрос, он тоже нас полностью удовлетворяет. Находим похожий запрос: "2001-2005, Lewis Media". Пробегая футеры далее находим следующий запрос: "SMFone design by A.M.A, ported to SMF 1.1". Проверяем - отлично. И так далее. Полчаса работы и у вас замечательная база запросов по движку, причем за данные запросы Гугл будет банить значительно реже, чем, если вы будете использовать в них операторы. И в то же время база у вас будет значительно чище, чем, если вы будете использовать запросы, типа "index.php?topic=", потому как тут Гугл будет отдавать не только нужные нам форумы, но и много левых ресурсов, где удалось оставить ссылку на топик форума. Вы можете возразить, мол, а что в этом плохого? Другие же оставили ссылку, значит и мы можем. Но! Ссылки может оставлять не только Хрумер, но и другие программы. причем они могут быть специально заточены для оставления комментариев в определенный ресурс, так называемый узкоспециальный софт, плюс такие ссылки могли быть оставлены руками. Опять повторюсь, нам не количество мусорное важно, а качество, базу правильными запросами мы и так соберем. Плюс данного метода еще и в том, что вам практически не нужно будет в Хрефере настраивать sieve-filter, его можно будет попросту отключить, ведь Гугл вам практически не будет отдавать мусора.Считаю, что научиться на начальном этапе грамотно пользоваться Хрефером очень важно, ведь научившись этому можно всегда найти применение Хрумеру, как бы не менялась ситуация. Защиты усложняются, и если на каких-то типах движков усилили защиту и с ней не справляется в данный момент Хрумер, то нет смысла тратить ресурсы на сбор данных линков, а потом на работу по ним Хрумером, лучше сосредоточить силы на том, что даёт результат. И в то же время, если команда Ботмастер Лабс обучила Хрумер чему-то новому, можно оперативно препарировать нового пациента и подготовить базу Хрумеру, пока пациент еще тепленький. Время - деньги, ресурс может быть уже не актуальный, когда вы купите базу. собранную кем-то. Кроме того правильное собирание баз под себя значительно расширяет "белое" применение Хрумера. А это именно то, куда все и движется, хотим мы того или нет, а процесс беления или серения идет. Черные простыни по чему только можно уходят в прошлое.

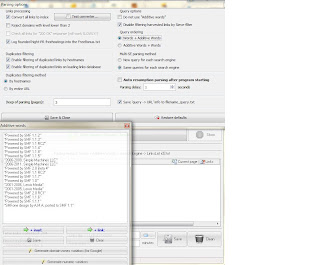

Все остальные, уже технические моменты работы с Хрефером можно посмотреть в хелпе и останавливаться на них не имеет смысла, все голы-очки-секунды выставляются опытным путём для каждой машины индивидуально.

В качестве бонуса выложу здесь шаблон для парсинга китайского поисковика Baidu, на днях у меня про него спрашивали, вот сделал между делом, извините за каламбур. :)

[Baidu]

Hostname=http://www.baidu.com

Query=s?wd=[QUERY]

LinksMask=<a onmousedown="[...]" href="[LINK]"target="_blank">

TotalPages=100

NextPage=<a href="[LINK]" class="n">

NextPage2=<a href="[LINK]" class="n">

CaptchaURL=

CaptchaImage=

CaptchaField=

Hostname=http://www.baidu.com

Query=s?wd=[QUERY]

LinksMask=<a onmousedown="[...]" href="[LINK]"target="_blank">

TotalPages=100

NextPage=<a href="[LINK]" class="n">

NextPage2=<a href="[LINK]" class="n">

CaptchaURL=

CaptchaImage=

CaptchaField=

Пробовал им тестово попарсить, бана не было, ресурсы Хрефер собирал живо, все запросы для парсинга аналогичные Гугловским, но ресурсов китайских - море, причем с высоким ПР, а кроме того, много куда там не ступала нога европейца. Парсить лучше китайскими запросами. В этом поможет Гугл-транслейт, набираете список ключевиков по-русски и переводите это на китайский. Правда в "вордс" Хрефера слова нельзя складывать на китайском, нужно перекодировать.

Вместо китайских:

伟哥 - виагра

吉他 - гитара

其他 - отдых

保险公司 - страховка

Положить в файл вордс вот эти коды их замещающие:%E4%BC%9F%E5%93%A5

%E5%90%89%E4%BB%96

%E5%85%B6%E4%BB%96

%E4%BF%9D%E9%99%A9%E5%85%AC%E5%8F%B8

Если вы продвигаете сайт по страховкам, то разместив ссылку в профиле на тематичном (!) даже китайском форуме найденному по запросу "форум СМФ" 保险公司 будет очень неплохо.В заключение хотел бы сказать, что никогда не понимал людей, которые жаловались на то, что Хреферы плохо либо не то парсят, на это всегда хотелось сказать, вы просто не умеете их готовить. Лучше хрефера ни один парсер не умеет собирать выдачу, просто запросы должны быть правильные. Хрефер - машина: хорошая, добротная, сделанная по-немецки, но управляет ей человек и все зависит от того, на сколько толково ей управляют, нельзя одновременно заставлять ехать машину и направо и налево.

Отдельная тема - чистка баз, я когда-то 3 года назад для предыдущего конкурса кое-что писал на эту тему. С большего там по прежнему все актуально, но от проверки на 200 ОК теперь можно отказаться, мне правда этот процесс не особо и нравился, очень погрешности были большие, много лишнего отфильтровывалось. Теперь это можно делать практически на автомате в процессе работы Хрумера, хоть данный процесс и не является полным аналогом проверки на "200 ОК". Вобщем, к делу: не так давно в Хрумере появилась замечательная возможность - граббить информацию с ресурсов в момент прогона проекта. Выглядит это так. Вы вбиваете шаблон, который в процессе работы будет обрабатываться, и собранная по шаблону информация будет заноситься в файл xgrabbed.txt в папке Logs. Применять эту функцию можно для чего угодно, полет фантазии огромный. Я раз в неделю использую эту функцию для удаления из рабочей базы "экспиред" ссылок. Не секрет, что форумы отмирают каждый день, чтобы почистить от таких ресурсов базу нам и поможет в данном случае инструмент "Автограббинг".

Ведь согласитесь, частенько набирая, например, http://www.laptopace.com/index.php мы видим, что доменом этим уже, например, гоудядя барыжит, а форума там нету. Так вот чтобы выкинуть из базы этот шлак, будем граббить. :) Открываем исходный код страницы и видим там данную запись:

<div id="domainname1"> laptopace.com </div>Для граббинга преобразуем её в <div id="domainname1">[...] </div>

Теперь все "мертвецы" от гоудадди нам будут известны поимённо.

Вот небольшая подборка для инструмента "Автограббинг", если вы захотите почистить базу от разных "экспиред" доменов:

<area shape=rect coords="[...]" href="http://www.000webhost.com/order.php" target="_parent" alt="Order Now" title="Order Now">

<div id="domainname1">[...] </div>

<title>[...]</title><meta name="robots" content="index, follow, all" ><meta name="GOOGLEBOT" content="index, follow, all" ><meta name="expires" content="NOW" >

<frameset rows="*" framespacing="0" border="0" frameborder="NO">[...]</frameset>

</script><frameset rows="100%,*" frameborder="no" border="0" framespacing="0">[...]</frameset>

<frameset rows="100%"><frame src=[...] frameborder="0" noresize="noresize"/>

<a href='/.html' style='text-decoration:none'><span class='domain'>[...]</span></a>

<div class="custom_1"><span class="forSale">This domain may be for sale. [...]Buy this Domain</a></span>

<body marginwidth="0" marginheight="0" leftmargin="0" topmargin="0"><iframe width="100%" height="100%" frameborder="0" SCROLLING="auto" marginwidth="0" src="[...]"></iframe></body>

<frameset rows="100%,*" frameborder="no" border="0" framespacing="0">[...]<noframes><body bgcolor="#ffffff" text="#000000"><div id="domainname1">[...] </div>

<title>[...]</title><meta name="robots" content="index, follow, all" ><meta name="GOOGLEBOT" content="index, follow, all" ><meta name="expires" content="NOW" >

<frameset rows="*" framespacing="0" border="0" frameborder="NO">[...]</frameset>

</script><frameset rows="100%,*" frameborder="no" border="0" framespacing="0">[...]</frameset>

<frameset rows="100%"><frame src=[...] frameborder="0" noresize="noresize"/>

<a href='/.html' style='text-decoration:none'><span class='domain'>[...]</span></a>

<div class="custom_1"><span class="forSale">This domain may be for sale. [...]Buy this Domain</a></span>

<body marginwidth="0" marginheight="0" leftmargin="0" topmargin="0"><iframe width="100%" height="100%" frameborder="0" SCROLLING="auto" marginwidth="0" src="[...]"></iframe></body>

Список далеко не полный, но думаю он поможет не гонять многомиллионные базы мусора многократно. Создать шаблон не сложно, открываете экспиред-ссылку и делаете маску шаблона.

При помощи того же автограббинга можно и ваши существующие базы прошерстить и рассортировать по ресурсам, разбив по движкам.Сортировка баз по движкам позволит оптимальнее использовать все возможности и настройки Хрумера, в частности процесс обучения. А кроме того при помощи Автограббинга вы можете удалить мусор из баз, если вы предпочитаете их собирать не Хрефером, а скачивая со всевозможных файлообменников. Для этого вам нужно либо сделать маску для отбора форумов и потом из базы собрать только то, что сграббится по маске, либо наоборот сделать маску для нефорумов и потом удалить то, что сграбится. Первый вариант логичнее и надежнее, потому что мы точно знаем, что искать.

Успехов в работе.

ПыСы. Видео сделал узконаправленное (намучился с ним, первый раз делал :) ), правда запускал Хрефер с домашней машины, скорость нета не очень хорошая, тут у меня копии только для тестов стоят, так что не обессудьте за скорость работы. :)

16 комментариев:

Какой программой вы подбирали ключевые слова?

если мне нужно собрать тематичные ресурсы, то слова в Вордс подбираю ручками и через Адвордс. но по многим темам к меня уже подобраны слова, тут только может добавляю-удаляю какие-то слова, но тоже не автоматом, а просматриваю их все.

это получается, что по каждому кею надо брать из адресной строки браузера код замещения?

отдых - 娛樂 - %E5%A8%9B%E6%A8%82

нет, ну, что вы.

у меня скрипт есть, заказывал, он не только кодирует-декодирует, но и еще кое-что для меня делает.

но можно вот этим воспользоваться: https://www.google.com/search?q=UrlEncode

например, http://meyerweb.com/eric/tools/dencoder/

вставляете иеродлиф и нажимаете Энкоде.

жаль что на данном сайте нельзя списком кодировать. он склеивает данные. Но можно исхитриться. уже объяснял кому-то ранее, что можно вводить слова примерно так:

伟哥11111

吉他11111

其他11111

и т.д. добавляя в конце иероглифа что-то типа 11111 (короткое не подойдет). потом закодировать это и например в нотепаде++ регуляркой заменить 11111 на перенос строки. получите на выходе ключи по одному в столбик. именно так нам и нужно.

Добрый день, Сергей, являюсь читателем вашего чудо-блога. Как новичок, в использовании хрумера, нахожу здесь уйму полезного.

Сначала были попытки парсинга стандартных признаков с 1000 ключевых слов, старт был довольно шустрый - за первые 5 минут скорость сбора ссылок была очень хорошая, потом - фактически останавливалась. Почитав, что Гугл банит за использование операторов inurl и прочих подобных собрал признаки парсинга чисто текстовые, заключенные в кавычки. По типу "powered by smf 1.1.4", вышло больше 120 признаков разных популярных форумов. Собрал базу кейвордов по тематике, 23К слов. На этом думал мои беды закончатся, но нет. Ситуация была фактически такая же. Потом скорость парсинга снижалась. После остановки и снова старта скорость была отличная. Приходилось по 10 раз нажимать стоп-старт. В итоге за пол дня еле набежало 20К форумов.

Вопрос - в чем может быть дело: в настройках(Анти-баны, потоки), в прокси (использую HTTP), в IP (статический, уже писали не раз, что он попал в СтопФорумСпам)? И что нужно делать, чтобы сравнительно быстро собирать базы по форумов по ключам?

Подскажите пожалуйста, в чем причина.

и Вам добрый день. по всей видимости я на этот Ваш вопрос уже ответил на форуме (он у Вас там правда чуть короче был).

если вы используете дефолтные прокси, то это изначально огромный минус в работе. я там дал одну ссылку на топик форума, где обсуждалось как собирать свой лист, но такие топики были еще. потратьте немного своего времени на сбор своих прокси- (сокс-) листов и результаты вас порадуют. еще стоит поиграться с паузами. ну, и на счет аддитив вордс. не ограничивайте запросы только "футерными" записями, если рассмотреть несколько форумов на одном и том же движке, то можно найти ряд закономерностей присущих однотипным форумам.

На форуме ответили купить прокси) Я бы и рад купить, но не знаю какие лучше для сбора, какие лучше для постинга - соксы, http, сколько их брать.

Подскажите пожалуйста - для постинга что лучше использовать, соксы или хттп - из соображений пробива и успешных задач, естественно. Т.к читал, что лучше соксы, но на практике больше успешных при постинге через хттп. Вот такая незадача.

Спасибо вам за советы и блог, очень приятно читать, сразу чувствуется Ваш профессионализм. Ждем новых статей:)

я вам на форуме ответил, что лучше собрать самим. у меня собирают разные хреферы и через прокси, и через соксы. не принципиально. главное их более-менее уникальность и их количество. и более-менее уникальность запросов.

ну, и на счет профессионализма. :) не преувеличивайте. статьи, которые здесь пишу больше основаны на моем опыте работы с хрефером и хрумером, это несколько иная вещь, чем профессионализм. :) поэтому, если вы где-то прочитали, что лучше действовать так, а по вашему опыту результат лучше получается, если действовать иначе, то руководствуйтесь своим опытом. Статьи пишутся, но условия у всех несколько отличаются, и что русскому хорошо, то ... дальше вы знаете. если у вас лучше результат через прокси, а не через соксы, то используйте прокси и не слушайте советов, которые противоречат вашей практике.

Но в любом случае потрудитесь собрать свои прокси- и сокс-листы. тогда сравнение будет более точным, на дефолте могут влиять многие побочные факторы, например, в данный момент именно соксы или прокси используют максимальное (минимальное) количество юзеров.

Огромное спасибо за статью, а то где на форумах про хрефер не посмотри - везде дата последних постов колеблется от 2008 до 2009 года, сейчас буду пытаться собрать собственные признаки для additive words, с прокси вроде более менее разобрался, а метод "стоп-старт" почему то и впрямь работает хоть это и похоже на бред.

рад, что информация оказалась полезной для вас

подскажите пожалуйста ссылку на форму,где вы описали про то как собрать свой список прокси.

ссылку на форум хрумера дать не могу. он закрытый и там это не приветствуется.

но вот пост, о том, как примерно нужно действовать (по четким фразам из этого поста, найдете там всю ветку):

1. Берем одну любую рабочую http или socks проксю. Пусть это будет http прокся 133.11.240.57:3124. Копируем ее адрес без порта и добавляем слово proxy. Смотрим результаты в гугле по нашему запросу. Находим среди всего этого хлама списки, которые обновляются достаточно часто, т.е. не реже одного раза в день. Во многих листах пишется дата последнего обновления и частота обновлений. Сразу лучше исключать списки, публикуемые на форумах. Поверьте, так будет лучше. Листов в интернете море. Просматривайте выдачу гугла как можно глубже, там тоже много вкусного.

2. Далее, берем ОДИН найденный проксилист и вставляем его адрес в файл list.txt в папке proxyc. Тестим этот лист в хрефере. Многие листы могут не парситься или могут не открываться из-за большого числа обращений к ним и т.д. и т.п.

3. Допустим, лист удачно спарсился и в нем есть рабочие прокси. Еще одним критерием того, что мы будем считать этот лист хорошим, станет процент рабочих проксей от общего числа проксей в списке. Я для себя решил, что если от общего числа проксей в листе примерно 20% будут рабочими, то это гуд.

4. Записываем адрес найденного хорошего листа в отдельный файл. Копируем найденные в нем рабочие прокси в куда нибудь, чтобы потом продолжить поиск листов по их адресам. Очищаем файл xproxy.txt в папке с хрефером, чтобы они нам в дальнейшем не мешали искать новые. Удаляем адрес прокси листа из файла list.txt в папке proxyc.

5. Далее по кругу начиная с первого пункта.

Очень важно, чтобы при чеке проксей интернет-канал был максимально свободен. Также важна скорость отклика вашего сервера, на котором лежит папка proxyc. Ставьте таймаут чека проксей не больше 3 секунд.

Итог: За 3-4 часа так можно собрать очень большой список листов с хорошими прокси абсолютно БЕСПЛАТНО. Пользуйтесь и экономьте деньги.

Отличный Блог, спасибо огромное за статью!

С проксями поступил следующим образом, нашел софт - "ProxyGoblin" он и помогает добывать.

варианты есть. вот и недавно на форуме неплохой урок как это сделать появился. но опять-таки ссылку дать не могу, это не приветствуется.

главное, чтобы результат был, а как это сделать каждый уже решает для себя.

удачи вам в работе.

Serge Glazko, а зачем ссылку давать ? Вы закопипасте с переделкой, думаю народ оценит.

так человек же уже сделал работу, расписав как и что. :) не хочу плагиатом заниматься. там, кстати, на форуме ботмастера месяца полтора назад появился более свежий урок, как собирать прокси хрефером. советую почитать.

Отправить комментарий